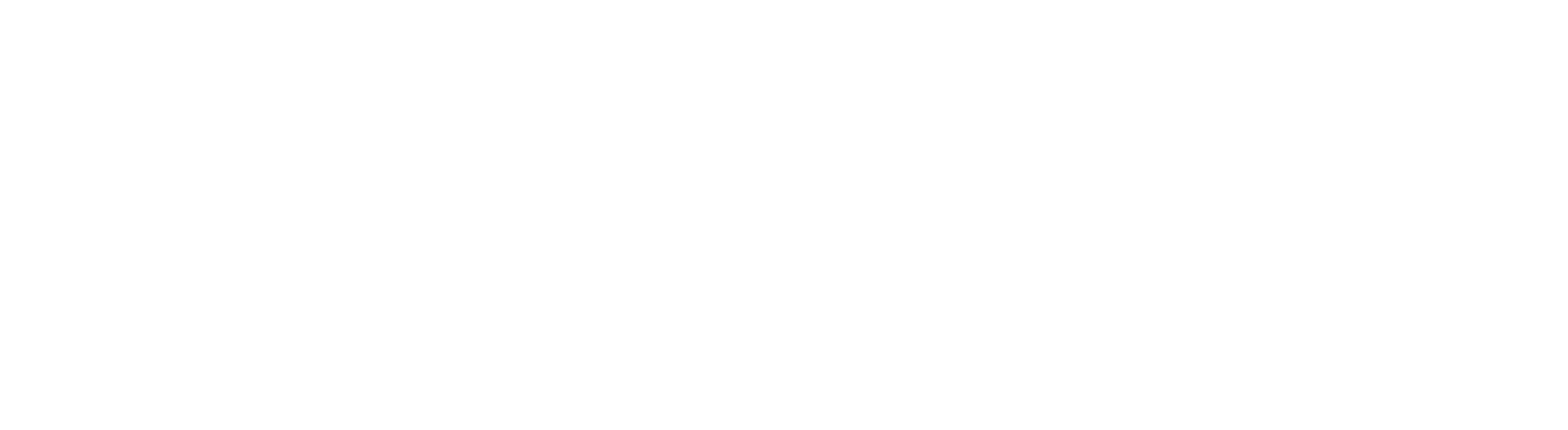

El origen de las cadenas de Markov

Las cadenas de Markov fueron desarrolladas por el matemático ruso Andrey Markov a principios del siglo XX (1906). Markov quería demostrar que los fenómenos dependientes podían analizarse sin necesidad de conocer toda la historia previa. Su objetivo era mostrar que incluso en secuencias complejas, las probabilidades del siguiente evento podían inferirse únicamente a partir del estado actual.

Un ejemplo clásico: Markov analizó secuencias de letras en los poemas de Pushkin para calcular la probabilidad de que una vocal siguiera a una consonante. Este enfoque rompió con la idea predominante de la época, que requería estudiar la historia completa de los eventos, y abrió la puerta a modelos memoria-corta pero estadísticamente potentes, capaces de simplificar procesos complejos.

Usos modernos de las cadenas de Markov

Hoy, las cadenas de Markov se aplican en múltiples campos:

- Procesamiento de lenguaje (NLP): Generación de texto y predicción de palabras; fundamento conceptual de los modelos autoregresivos como los LLM.

- Economía y finanzas: Modelado de precios de acciones y riesgo crediticio.

- Biología y genética: Secuencias de ADN y evolución de poblaciones.

- Ingeniería y ciencia de datos: Sistemas de recomendación, simulaciones de procesos estocásticos.

- Juegos y simulaciones: IA para videojuegos y generación de entornos aleatorios.

- Buscadores: Google y su análisis de contenido o PageRank

El principio clave es que cada estado futuro depende únicamente del presente, lo que permite modelar secuencias complejas de manera estadísticamente manejable.

Feedback loops y riesgo en los LLM

Cuando un modelo de lenguaje se entrena sobre contenido generado por sí mismo u otras IA, se forma un bucle de retroalimentación (feedback loop). Esto puede causar un fenómeno conocido como model collapse, donde:

- El modelo empieza a reproducir sus propios errores y estilo, en lugar de aprender del lenguaje humano real.

- La diversidad semántica se reduce: se repiten estructuras y frases, perdiendo riqueza y creatividad.

- Se generan datos sintéticos con información inventada o inexacta, que contaminan futuros entrenamientos.

En términos matemáticos, es como una cadena de Markov que evoluciona hacia una distribución estacionaria pobre: después de varios ciclos, el output se vuelve repetitivo, monótono y menos fiable.

Ejemplo reciente: Wired y Business Insider

En agosto de 2025, Wired y Business Insider eliminaron artículos escritos por una supuesta autora freelance, “Margaux Blanchard”, que resultaron generados por IA y contenían fuentes inexistentes y anécdotas inventadas.

Si este contenido se utilizara como dato de entrenamiento para futuros modelos, los errores y falsedades se propagarían, degradando la calidad del conocimiento que la IA puede generar. Esto demuestra cómo un feedback loop de contenido sintético puede romper la confiabilidad de la información. https://www.theguardian.com/us-news/2025/aug/21/ai-author-articles-wired-business-insider

Cómo prevenir la contaminación de conocimiento

Para evitar que los LLM se “rompan” por datos sintéticos:

- Diversificar fuentes: incluir texto humano de alta calidad y variedad en el entrenamiento.

- Monitorear diversidad lingüística: métricas que detecten repetición excesiva o pérdida de riqueza semántica.

- Limitar el contenido sintético: usar IA generativa solo como complemento, nunca como la base exclusiva del dataset.

Conclusión

Los bucles de retroalimentación no son un bug menor: son un riesgo estructural. Si no se controlan, los LLM pueden producir contenido monótono, impreciso y poco fiable. La clave está en preservar la diversidad y calidad de los datos, asegurando que el conocimiento generado por IA siga siendo útil, confiable y creativo.